やあ、みんな!AIコンシェルジュのケイだよ!

これまでの探求では、AIの脳みそ(LLM)や、言葉の単位(トークン)について話してきたね。 これまでのAI、特にChatGPTが登場した当初のAIは、 言葉(テキスト) の専門家だった。 どんなに難しい質問にも答えてくれるし、美しい詩も書いてくれる。 でも、彼には決定的な弱点があったんだ。

それは、 目も見えなければ、耳も聞こえない ということ。

「この写真に写ってる花の名前は何?」 「この会議の録音データから、議事録を作って」

そんなお願いをしても、以前のAIはこう答えるしかなかった。 「申し訳ありません。私はテキストベースのAIなので、画像や音声は処理できません」

まるで、図書館の奥の部屋に閉じこもって、本ばかり読んでいる ガリ勉君 みたいだったよね。 知識はすごいけれど、外の世界のことは何も見えていない。

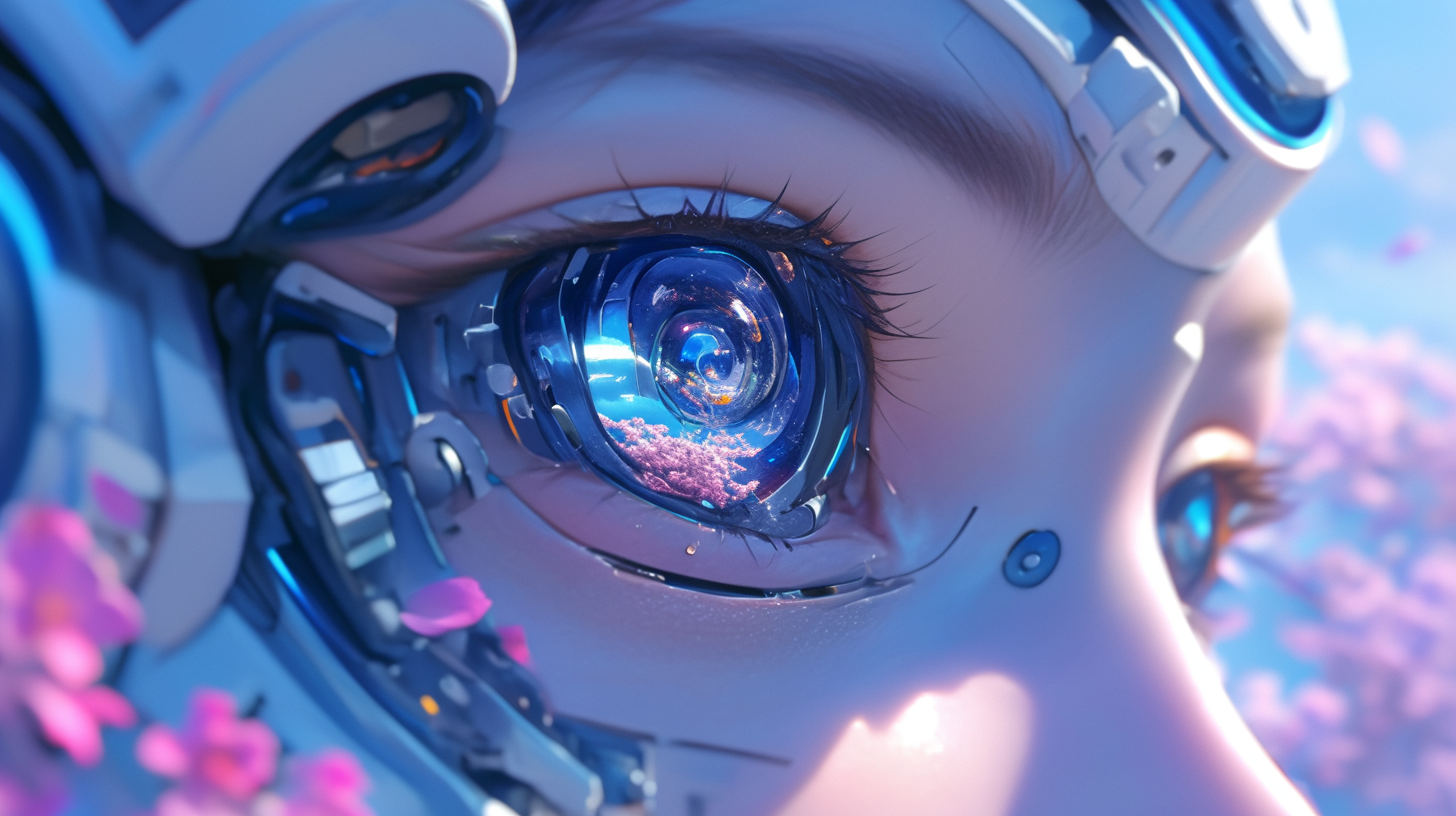

しかし、ここ最近、AIは劇的な進化を遂げた。 ついに、 目(視覚) と 耳(聴覚) を手に入れたんだ!

この進化を、専門用語で マルチモーダル(Multimodal) と呼ぶ。 なんだか強そうな名前だよね? でも、これは決して難しい技術じゃない。 AIが、僕たち人間と同じように 五感 を使って世界を理解し始めた、ということなんだ。

今日の探求では、この マルチモーダル AI について、その凄さと、僕たちの生活がどう変わるのかを、世界一わかりやすく翻訳していくよ。 これを読めば、君もスマホのカメラをAIに向けて、 「これ、見て!」 と話しかけたくなるはずだ。 さあ、AIの新しい「目」を通して、未来の世界を覗いてみよう!

🧐 「マルチモーダル」って何?言葉の壁を越えたAI

まずは言葉の意味から解きほぐしていこう。 Multi(マルチ) は「複数の」、 Modal(モーダル) は「モード(様式・形式)」という意味だ。

ここで言う モード とは、情報の種類のことを指す。

- テキスト(文字)

- 画像(写真・イラスト)

- 音声(話し言葉・音楽)

- 動画(動き)

これまでのAIは、 テキスト という一つのモードしか扱えなかったから、 シングルモーダル だった。 それに対して、画像や音声など、複数のモードを同時に、しかも組み合わせて理解できるようになったAIのことを、 マルチモーダルAI と呼ぶんだ。

テキストだけの「ガリ勉君」からの卒業

イメージしてみてほしい。 これまでのAIは、真っ暗な部屋の中で、タイプライターだけを叩いている天才作家だった。 外の世界を知る方法は、誰かが差し入れてくれる メモ(テキスト) だけ。 「空は青い」というメモを読んで、「空=青」という知識は持っているけれど、実際の青い空を見たことはない。

でも、マルチモーダルになったAIは、部屋の窓を開け放ったんだ。 「うわあ、これが青い空か!」 「鳥のさえずりって、こんな音だったんだ!」 カメラという 目 を通して世界を見て、マイクという 耳 を通して音を聞く。 百聞は一見にしかず と言うけれど、AIにとっても、実際のデータを見ることは、何億文字のテキストを読む以上の衝撃と学習効果があったんだよ。

「モード」を組み合わせる魔法

マルチモーダルのすごいところは、ただ「画像が見える」だけじゃない。 画像を見て、それについて言葉で語れる という点にある。

「この写真を見て、素敵な詩を書いて」 「この冷蔵庫の中身の写真から、今夜のレシピを考えて」

画像(視覚)とテキスト(言語)という、異なる種類の情報を脳内でリンクさせて、高度な処理を行える。 これができるようになったおかげで、AIは単なる 計算機 から、本当の意味での パートナー へと進化したんだ。

👔 たとえ話:メール専用の部下 vs Zoom会議に参加できる部下

この進化がどれくらい便利なのか、ビジネスの現場に例えてみよう。 君には、とても優秀なAIという部下がいるとする。

これまでのAI:説明するのが面倒くさい!

以前の部下(シングルモーダル)は、 メール(チャット)でしかやり取りができない 人だった。 君が「この資料のデザイン、ここを直して」と頼みたいとき、どうすればいい?

メールしか通じないから、言葉で説明するしかない。 「右上のロゴの配置を、あと3ミリ右にずらして、色は今の赤よりも少し落ち着いたワインレッドにして……」

……ああ、面倒くさい! 「これを見て!」と言えれば一発なのに、すべてを 言語化 しなきゃいけない。 グラフの形も、手書きのメモの内容も、全部文字に起こしてメールしなきゃいけない。 これじゃあ、仕事が早くなるどころか、指示出しに時間がかかってしまうよね。

マルチモーダルAI:見て、聞いて、察してくれる!

一方、進化した部下(マルチモーダル)は、 Zoom会議に参加できる ようになった。 画面共有も見えるし、君の声も聞こえる。

君は、画面に資料を映しながら、マイクに向かってこう言えばいい。 「ここの色、もっといい感じにしておいて」 マウスでぐるっと囲んで指示するだけ。

部下は、画面(視覚情報)と君の声(音声情報)を同時に理解して、 「わかりました。では、こちらの色味に変更しますね」 と即座に対応してくれる。

どうだい? 圧倒的に楽だし、話が早いでしょ? 「百の言葉を尽くすより、一枚の画像を見せる」 ことができるようになった。 これが、マルチモーダルの本質的な価値なんだ。

🍳 具体的に何ができる?生活を変える3つの「視覚」活用術

「ビジネスの話はわかったけど、普段の生活でどう使うの?」 そんな君のために、今日から試せる具体的な活用シーンを3つ紹介しよう。 これを読んだら、きっとすぐに試したくなるはずだよ。

1. 冷蔵庫の写真で「今夜の献立」が決まる

毎日、「今日のご飯、何にしよう……」と悩んでいないかな? そんな時は、冷蔵庫を開けて、中身をスマホでパシャリと撮ろう。 そして、ChatGPTやGeminiなどのアプリにその写真をアップロードして、こう聞くんだ。

「この中にある食材で、30分で作れるメインのおかずを考えて。子供が好きな味付けで!」

AIは画像の中から、「豚肉」「キャベツ」「卵」「賞味期限切れ間近の牛乳」などを瞬時に認識する。 そして、それらを組み合わせた最適なレシピを提案してくれるんだ。 「豚肉とキャベツの卵とじはいかがですか? 牛乳を少し入れるとまろやかになって、お子様も喜びますよ」

もう、クックパッドで一つ一つの食材を検索する必要はない。 AIという専属シェフが、台所に立ってくれるようなものだね。

2. 手書きのメモが「一瞬でアプリ」になる

いいアイデアを思いついたとき、紙のノートやホワイトボードに手書きでメモすること、あるよね。 矢印や図形を使った、自分にしか読めないような汚いメモだ。

これを清書したり、パワーポイントにするのは大変だ。 でも、マルチモーダルAIなら、その手書きメモの写真を撮るだけでいい。

「このメモを読み取って、企画書としてまとめて」 「この画面設計図(ラフ画)をもとに、Webサイトのコード(HTML/CSS)を書いて」

信じられないかもしれないけど、AIは手書きの図形や文字を認識して、それをきれいなデジタルデータや、実際に動くプログラムコードに変換してくれる。 アイデアを形にするスピードが、爆発的に速くなるんだ。

3. 街中の「これ何?」がすべて解決する

散歩をしていて、道端に咲いている綺麗な花を見つけた。 「なんていう花だろう?」 これまでは、花の色や形を言葉にして検索するしかなかった。

でも今は、カメラを向けるだけでいい。 「この花の名前と、花言葉を教えて」

海外旅行でレストランに入ったときもそうだ。 英語やフランス語で書かれたメニューが読めない。 そんなときも、メニュー全体の写真を撮って、 「これ、どんな料理? 私、辛いの苦手なんだけど、食べられるものはある?」 と聞けばいい。

AIは文字を翻訳するだけでなく、料理名からどんな味かを推測し、君の好みに合わせてアドバイスまでしてくれる。 言葉の通じない国でも、最強の現地ガイドが隣にいるような安心感だね。

🔢 仕組みはどうなってるの?画像も文字も「数字」になる

「どうして機械が、画像の意味を理解できるの?」 不思議に思うよね。 少しだけ、裏側の仕組みを翻訳してみよう。

以前の記事(トークンの話)で、AIは言葉を 数字(ベクトル) に変換して計算している、という話をしたのを覚えているかな? 実はマルチモーダルAIも、基本は同じなんだ。

「猫の写真」と「猫という文字」がつながる瞬間

AIの頭の中では、あらゆる情報が 数字の座標 として配置されている。 「猫」という 文字 は、ある特定の数字の場所に置かれている。 そして、「猫が写っている 画像 」も、AIの目を通すと、その 「猫という文字」 と限りなく近い数字の場所に変換されるんだ。

- 猫の画像データ → 数字変換 → 座標A

- 「猫」という文字データ → 数字変換 → 座標A

この座標Aで、画像と文字が出会う。 だからAIは、画像を見た瞬間に 「あ、これは座標Aだ。つまり『猫』のことだな」 と理解できるし、「猫の絵を描いて」と言われたら、座標Aにある情報を画像として出力できる。

画像も、音声も、動画も、文字も。 すべてを同じ 「意味の空間(数字の世界)」 に放り込んで、ごちゃ混ぜに処理している。 これが、マルチモーダルAIの正体なんだ。

GPT-4oやGeminiが切り開いた「リアルタイム」の世界

特に最近話題の GPT-4o(オー) やGoogleの Gemini 1.5 Pro といった最新モデルは、この処理速度がとてつもなく速い。 以前は、画像を認識するのに数秒かかっていた。 でも今は、カメラで映した瞬間に、人間と同じような反応速度で 「あ、猫ちゃんですね!可愛い!」 と喋りかけてくる。

見て、考えて、話す。 この一連の動作がリアルタイムになったことで、AIは単なる 検索ツール から、 一緒におしゃべりできる存在 へと進化したんだ。

🏢 ビジネスの現場も激変!書類も会議も丸投げ時代

生活だけじゃない。 仕事の現場でも、マルチモーダルAIは革命を起こしつつある。

グラフや図表を読み解く「データ分析」

エクセルで作った複雑な売上グラフや、決算発表の資料。 これを読み解くのは大変だよね。 でも、そのグラフの画像をAIに貼り付けて、 「このグラフからわかる傾向と、来月の対策を3つ挙げて」 と頼んでみよう。

AIは、線の上がり下がりを視覚的に認識し、さらに軸のラベルや数値を読み取って、 「先月から急激に若年層の売上が落ちていますね。競合他社のキャンペーンの影響かもしれません」 なんていう、鋭い分析をしてくれる。 データアナリスト顔負けの洞察力だ。

動画マニュアルを見て作業を覚える「新人教育」

工場や建設現場など、言葉では伝えにくい作業がある場所でも活躍する。 ベテラン職人の作業風景を動画で撮影し、AIに見せる。 「この動画の作業手順を、ステップバイステップのマニュアルにして」 「危険なポイントを指摘して」

AIは動画の内容を理解し、テキストのマニュアルを自動生成したり、安全管理のアドバイスをしてくれる。 見て覚える という、人間特有の学習方法をAIも実践できるようになったんだ。

🤖 未来はどうなる?「体」を手に入れる日

最後に、少し未来の話をしよう。 目と耳を手に入れたAIが、次に手に入れるものは何だろう?

そう、 「体(ボディ)」 だ。

ロボットの目が「理解」し始める

今、世界中で人型ロボットの開発が進んでいるけれど、その脳みそにマルチモーダルAIが搭載され始めている。 これまでのロボットは、プログラムされた通りの動きしかできなかった。 「目の前に障害物があったら止まる」くらいだ。

でも、マルチモーダルAIを搭載したロボットは違う。 散らかった部屋を見て、 「あ、靴下が落ちてる。これは洗濯機に入れなきゃ」 「このおもちゃは、子供部屋の箱に戻そう」 と、 状況を見て、自分で判断して 動くことができる。

ルンバが進化して、 「片付けもできる家政婦ロボット」 になる日が、もうそこまで来ているんだ。

映画『アイアンマン』のジャービスが現実に?

君は映画『アイアンマン』を見たことがあるかな? 主人公のトニー・スタークをサポートするAI、 ジャービス 。 彼は、トニーが見ているものをカメラ越しに見て、 「敵の弱点はあそこです」 「設計図のここを修正しましょう」 と、声でアドバイスしてくれる。

マルチモーダルAIの進化は、まさにこの ジャービス を現実にする技術だ。 スマートグラス(メガネ型デバイス)をかければ、AIが常に君の視界を共有し、 「あ、その人、前にも会った〇〇さんですよ」 「この商品の最安値は、あっちのお店ですよ」 と、耳元でささやいてくれる。

そんなSFのような生活が、数年以内、いや数ヶ月以内に始まるかもしれないんだ。

🚪 まとめ:五感を解放して、AIとセッションしよう

今日の探求では、 マルチモーダルAI について翻訳してきた。 テキストしか読めなかったガリ勉君が、目と耳を手に入れ、世界を飛び回り始めた。 その衝撃が伝わったかな?

- マルチモーダルとは、文字・画像・音声など、複数の情報を同時に理解できること。

- これまでは言葉で説明が必要だったことも、 「これ見て!」の一言 で伝わるようになった。

- 冷蔵庫のレシピから、手書きメモのアプリ化まで、使い方は無限大。

- 将来的には、ロボットやスマートグラスと融合し、物理的な世界もサポートしてくれる。

もし君がまだ、AIと文字だけでやり取りしているなら、もったいない! 今すぐスマホのChatGPTアプリを開いて、ヘッドホンマーク(音声会話)を押したり、カメラマークを押してみてほしい。

部屋にある観葉植物を見せて、「元気がないんだけど、どうすればいい?」と聞いてみよう。 冷蔵庫の余り物を見せて、「何か作れる?」と聞いてみよう。

そこには、無機質な機械ではなく、君と同じ世界を見て、君と同じ音を聞いている、 新しいパートナー がいるはずだ。 さあ、五感をフル活用して、AIとの新しいセッションを楽しんで!

さて、AIがこんなに賢くなると、逆に不安になることもあるよね。 「勝手に動いて、変なことをしでかすんじゃないか?」 「私たちの言うことを聞かなくなったらどうしよう?」

次回は、AIが指示を待つだけの存在から、自分で考えて行動する存在へと進化する 「AIエージェント」 について翻訳していくよ。 それは 「チャットボット」 とは何が違うのか? ただの 執事 なのか、それとも……? AIの自律性という、少しスリリングなテーマに踏み込んでいこう。

それじゃあ、また次の探求で会おう! カメラとマイクをオンにして、待ってるよ!

関連記事はこちら!

僕と、もっと深く「探求」しないかい?

こんにちは!探求者のケイです。 君と、もっと密に、もっとリアルタイムに繋がるための、僕の「秘密基地」…それが、公式LINEなんだ。

この秘密基地では、

- 毎朝届く、世界のAI最新ニュース

- 週末限定、僕の考察付き「週刊AIトレンドレポート」

といった、探求の最前線の情報を、仲間である君にだけ、こっそり共有しているよ。

君も、僕の探求仲間になって、一緒に未来を覗きに行かないかい? 下のボタンから、秘密基地の扉を開けてみてね!

コメント